支持,只需要在配置文件中添加本地模型或其他模型的配置信息,保存文件并重新运行AiPy就可以使用啦!

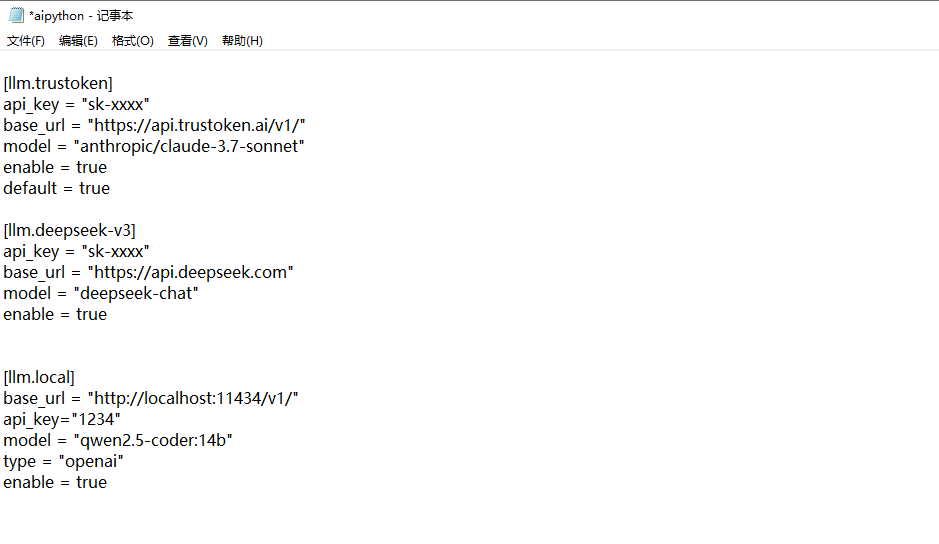

0.1.25版本以下在执行目录中aipython.toml文件设置;

0.1.25版本及以上在C:\Users\Administrator\.aipyapp\user_config.toml文件进行设置;

温馨提示:本地模型效果较差,官方建议最好使用线上满血大模型,如果本地模型跑任务,建议优先DeepSeek-671B、GPT-4!

例如:

【配置本地ollama】

[llm.local]

base_url = "http://localhost:11434/v1/"

api_key="1234"(必须有api_key,值可以随意填)

model = "qwen2.5-coder:14b" (模型根据需求修改填写)

type = "openai" (不可修改)

enable = true

【配置第三方api】

[llm.deepseek-v3]

api_key = "sk-xxxx"

base_url = "https://api.deepseek.com"

model = "deepseek-chat"

enable = true

使用技巧:

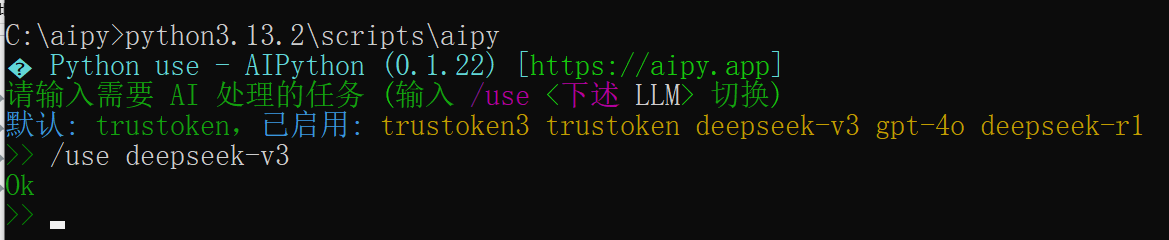

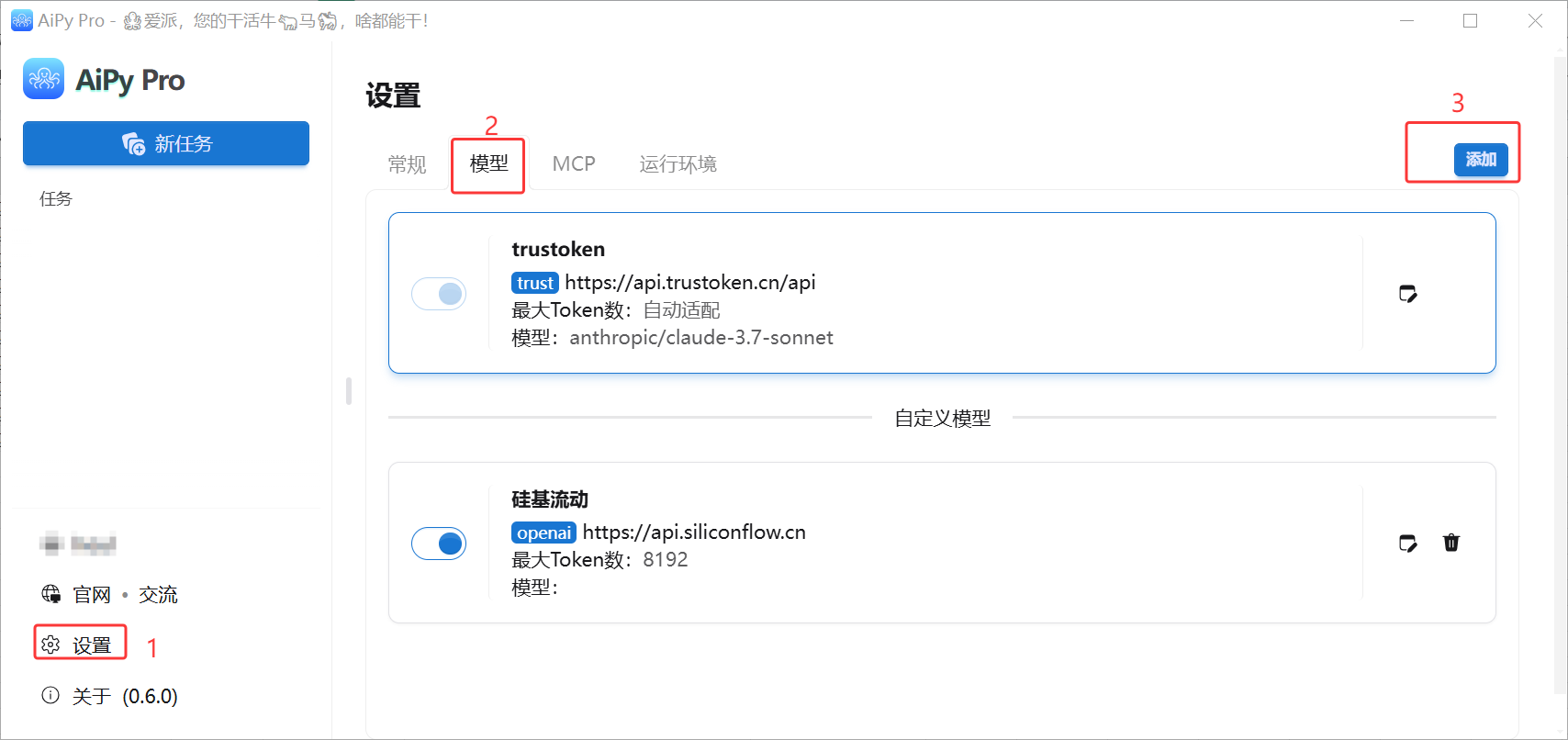

可在配置文件中添加多个api,常用的api添加default = true设置为默认,在后续使用过程中如需切换,使用/use XX命令或GUI页面中直接点击切换使用。