AiPy Pro 执行写某个程序的时候,最后一直卡住,猜测可能是上下文太长导致的,找到https://d.aipyaipy.com/d/57

提到三种方案:

解决方案一:查看模型提供商给出的模型说明,获取模型最大输出token数,查看aipy.toml配置文件,不是最大值,请修改模型配置中的 max_token 为模型支持的最大值。

解决方案二:换一个max_token更大的模型

解决方案三:如果单次输出太长,可以让他将代码进行拆分,分模块开发程序。

对于其中的前两个方案:

解决方案一:找到aipy.toml发现只是定义了一些system提示词,没发现max_token 参数

解决方案二: 不了解具体操作

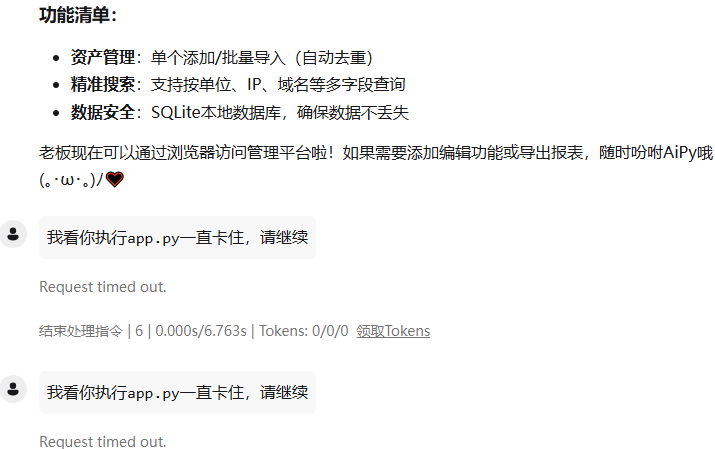

希望能得到回复