AiPy Pro现在默认只支持Trustoken上的模型,以及一些主流的大厂的模型,那如果要配置本地内网部署的模型,该怎么配,我找到方法了。

不过据官方说,本地部署的非满血版弄型效果真的很差,像傻子一样,本人实测也如此,请不要有太高期望!

步骤1:

编辑:C:\Users\Administrator\.aipyapp\config\llm.json文件,如果没有就创建一个。

步骤2:

在llm.json中写入下面的内容,注意里面的内容根据你的实际情况修改,据说如果没有密码的话api_key可以随便写,主要改base_url、model的值:

{

"LocalLLM": {

"type": "openai",

"name": "qwen",

"model": "dqwen2.5-coder:14b",

"base_url": "http://localhost:11434/v1/",

"api_key": "1234",

"max_tokens": 8192,

"enable": true,

"models": []

}

}

步骤3:

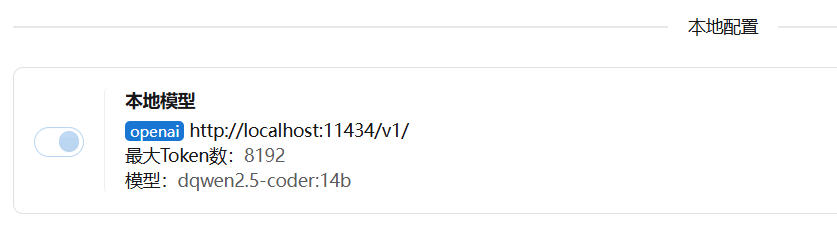

再去打开AiPy Pro的设置,你就会在最下面发现一个本地模型的内容:

步骤4:

然后就可以在对话框右下角的列表中选择本地模型了。